Aufgabe: Hat jemand Idee wie man Aufgabe 2.2 und 2.3 lösen kann?

Text erkannt:

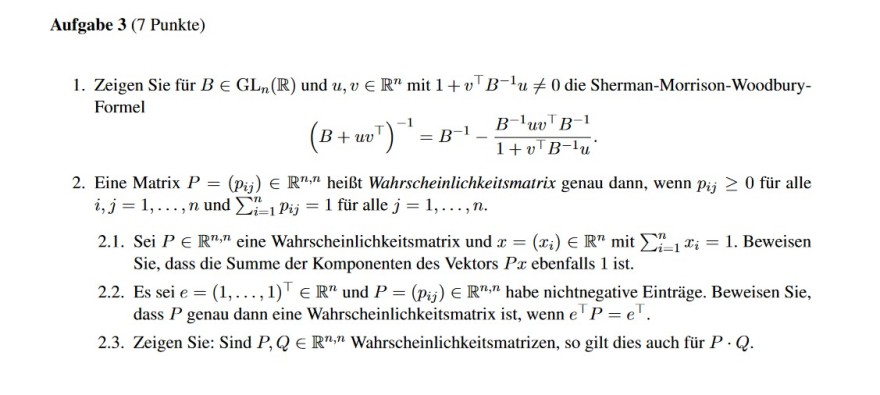

Aufgabe 3 (7 Punkte)

1. Zeigen Sie für \( B \in \mathrm{GL}_{n}(\mathbb{R}) \) und \( u, v \in \mathbb{R}^{n} \) mit \( 1+v^{\top} B^{-1} u \neq 0 \) die Sherman-Morrison-WoodburyFormel

\( \left(B+u v^{\top}\right)^{-1}=B^{-1}-\frac{B^{-1} u v^{\top} B^{-1}}{1+v^{\top} B^{-1} u} . \)

2. Eine Matrix \( P=\left(p_{i j}\right) \in \mathbb{R}^{n, n} \) heißt Wahrscheinlichkeitsmatrix genau dann, wenn \( p_{i j} \geq 0 \) für alle \( i, j=1, \ldots, n \) und \( \sum \limits_{i=1}^{n} p_{i j}=1 \) für alle \( j=1, \ldots, n \).

2.1. Sei \( P \in \mathbb{R}^{n, n} \) eine Wahrscheinlichkeitsmatrix und \( x=\left(x_{i}\right) \in \mathbb{R}^{n} \) mit \( \sum \limits_{i=1}^{n} x_{i}=1 \). Beweisen Sie, dass die Summe der Komponenten des Vektors \( P x \) ebenfalls 1 ist.

2.2. Es sei \( e=(1, \ldots, 1)^{\top} \in \mathbb{R}^{n} \) und \( P=\left(p_{i j}\right) \in \mathbb{R}^{n, n} \) habe nichtnegative Einträge. Beweisen Sie, dass \( P \) genau dann eine Wahrscheinlichkeitsmatrix ist, wenn \( e^{\top} P=e^{\top} \).

2.3. Zeigen Sie: Sind \( P, Q \in \mathbb{R}^{n, n} \) Wahrscheinlichkeitsmatrizen, so gilt dies auch für \( P \cdot Q \).